Wer macht denn sowas?

In diesem Fall werden die Maschinen für Steuerungsaufgaben eingesetzt und neuere Windows Versionen zicken bei den teilweise zeitkritischen Aufgaben rum.

Hardware:

Fujitsu Siemens Futro S500

- AMD Sempron 2100+

- 512MB Ram

- onboard CFcard Reader mit 16GB Kingston CF Karte ( 266x ultimate)

- Windows 2000 SP4

Ich schreibe hier ein paar Tipps auf, die mir im Laufe der Installation aufgefallen sind.

Mein externes USB-DVD Laufwerk zieht zu viel Strom, weshalb ich auf die Installation vom USB Stick gekommen bin. Hier kommen aber 2 Sachen zusammen:

Erstens: Es funktioniert wunderbar mit WinSetupFromUSB ( http://www.winsetupfromusb.com/downloads/ ) Die Installation lief durch, auch vergleichsweise schnell. Aber!

Zweitens: Die Compact Flash Disc wird von Windows als Removeable Disk erkannt. Windows bootet aber trotzdem. Jetzt zu meinem „Aber!“ von eben: Windows gibt sich selbst den Laufwerksbuchstaben D:, weil der USB Stick auch eine Removeable Disk ist und vor der CF Karte geführt wird (woher die Reihenfolge kommt, kann ich nicht sagen. Vielleicht ist das auf anderer Hardware anders).

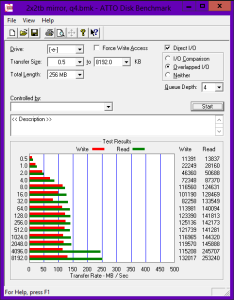

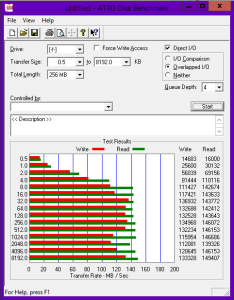

Prinzipiell wäre das kein großes Problem mit D: als Startplatte weiter zu arbeiten. Aber leider werden dann Zugriffe anders gepuffert und der Dateizugriff ist vergleichsweise langsam.

Jetzt gibt es 3 Methoden, die beide funktionieren um Windows vorzugaukeln, dass man eine normale Festplatte hat.

1) Man ändert das Bit in der CF Karte, das besagt, dass man eine Removeable Disk hat. Hierzu gibt es für verschiedene CF Karten Tools um das zu machen – für die von mir genutzten Kingston Karten leider nicht.

2) Man fügt die CF Karte in der Registry zu einer Whitelist hinzu:

HKLM\SYSTEM\CurrentControlSet\Services\atapi\Parameters\

in regedt32.exe öffnen (regedit.exe kann den Wert leider nicht richtig bearbeiten) und den Wert

NonRemovableMedia

bearbeiten. Hier fügt man eine Zeile mit dem Namen des Laufwerks hinzu, in meinem Falle

ULTIMATE CF CARD

Das kann man auch Automatisieren, indem man die Datei mshdc.in_ bearbeitet sie beinhaltet eine gepackte Version der entsprechenden .inf Datei und liegt auf der Windows CD im Ordner i386\. Man sucht die Zeile

HKR, Parameters, NonRemovableMedia, %REG_MULTI_SZ%, \

und fügt eine Zeile mit folgendem Inhalt ein:

"ULTIMATE CF CARD", \

Der Inhalt kann je nach CF Karte unterschiedlich sein und lässt sich hier aus der Registry auslesen:

HKLM\SYSTEM\CurrentControlSet\Enum\IDE\Disk\xxx\FriendlyName

Wobei xxx für das Laufwerk steht.

Wenn man die entsprechend präparierte Datei wieder in die gepackte mshdc.in_ kopiert und so auf die CD brennt, wird die CF Karte nach der Installation automatisch als Fixed Disk erkannt. Leider hilft einem das nicht bei der Installation, so dass es (wie bei mir) vorkommen kann, dass sich der Laufwerksbuchstabe durch den Wechsel des Laufwerkstyps verschiebt und Windows einen nach dem Login sofort wieder ausloggt. Wer die dabei entstehende Endlosschleife unterbrechen möchte, muss nur auf der Tastatur die Shift Taste gedrückt halten, dann kann man Windows zumindest regulär herunterfahren.

3) Die letzte Möglichkeit ist es, den Hitachi CompactFlash Fixed driver zu verwenden, wie zum Beispiel hier erklärt: http://vampiric.us/index.php/articles/hardware/cf/cftools

Bei mir hatte diese Version aber das gleiche Problem wie Lösung 2.

Nachdem ich einen aktiven USB Hub ausgekramt habe und Windows von CD installiert habe, hatte Windows dann auch C: als Laufwerksbuchstaben und der Hack #2 hat einwandfrei funktioniert.